Cela fait longtemps que j’évite de parler du sujet de la bulle de l’IA, même si j’avais posé la question dans une précédente newsletter.

Tout le monde a un avis sur le sujet, mais cette semaine, plusieurs signaux faibles permettent de mieux comprendre où l’on va et surtout, les angles de réflexion qui émergent.

Cette semaine, alors que l’actualité de l’IA tourne à son plein, j’ai eu l’occasion de faire deux interventions totalement orthogonales, en tout cas en apparence.

La première à l’occasion de la première édition du Government Tomorrow Forum, qui réunissait à Paris, ce qui est suffisamment rare pour être noté, plusieurs experts, hommes politiques et acteurs d’administration du monde entier pour réfléchir aux évolutions de leur secteur.

Là, nous avons parlé de la géopolitique des machines intelligentes et de l’industrie de l’IA qui est, comme vous le savez, à un moment charnière dans sa capacité à se financer ou se refinancer.

La seconde était organisée par la galerie berlinoise Stallman autour d’une conversation avec l’artiste ukrainien Daniel Spikov sur les intersections entre l’art et l’IA. Nous n’avions que 40 places et, surprise agréable, les personnes de l’audience sont restées près de deux heures pour prolonger la conversation dense que nous avons eue.

D’un côté, l’explosion de l’infrastructure et ses conséquences géopolitiques (data, énergie, eau…), et de l’autre, l’objet de fascination que représente l’espace latent (relire ma newsletter).

J’aime décrire l’espace latent comme un subconscient de l’IA, entraîné par des humains à partir de culture humaine. Pour l’artiste, mais aussi pour chacun d’entre nous, il devient une forme d’extension de la créativité humaine, quand ChatGPT ou Claude se veulent une extension de notre capacité de réflexion.

Cet espace invisible et incompréhensible par l’être humain n’apparaît, un peu comme le développement d’une photo dans un labo argentique, que lorsque nous utilisons des outils comme Midjourney, Nano Banana ou Udio pour le son.

Dans une précédente newsletter, j’avais parlé de l’entropie croisée et de l’espace latent, et de ce que cela représente d’un point de vue philosophique.

Cette semaine, j’avais envie de revenir à des choses plus terre à terre, à savoir si nous sommes dans une bulle IA, ou pour être plus précis dans une bulle de l’infrastructure IA.

Depuis les débuts tonitruants de ChatGPT, la majorité de l’argent levé, prêté ou échangé s’est fait dans l’infrastructure.

N’oublions pas qu’une partie du “seed money” de Microsoft à OpenAI s’est faite en crédits Azure pour le compute.

Le crédit en compute est fascinant car il attache la destinée d’un acteur à un opérateur de cloud et d’IA spécifique. Il convertit immédiatement l’investissement en chiffre d’affaires pour ce dernier. Nvidia, le grand vainqueur à ce jeu, s’est garanti qu’une partie non négligeable des investissements dans l’IA se convertissait en achat de puces de sa marque.

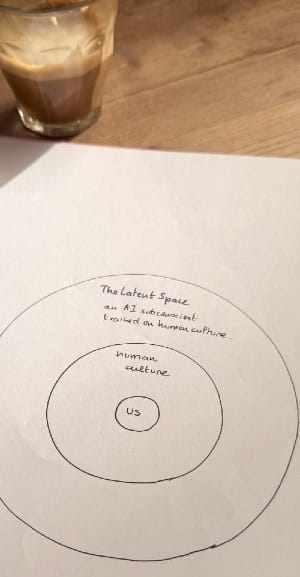

Au point que, malgré sa capitalisation boursière stratosphérique, Nvidia a une valorisation en termes de ratio P/E plus basse qu’il y a cinq ans. C’est-à-dire que ses bénéfices ont rattrapé son prix.

Naturellement, le sentiment de bulle actuel fait penser à la bulle des télécoms de 2000, qui n’était pas une bulle internet, car la chute de l’internet n’est que la conséquence du crash de WorldCom.

J’habitais à l’époque à San Francisco, le Ground Zero de cette bulle.

J’y vois toutefois une grande différence avec aujourd'hui.

La bulle des télécoms était surtout une bulle de la fibre noire. Bien qu’on ait surinvesti et surinstallé à la fin des années 1990, ce réseau de câbles était tout à fait utilisable des années après, quand la demande est arrivée.

Aujourd’hui, le surachat en puces Nvidia, dont la durée d’amortissement est très faible, interroge. De plus, comme tout produit, dès qu’on l’ouvre pour l’installer (même si les puces Nvidia sont livrées par palettes déjà préconfigurées, un cloud dans le cloud, NDR), elles perdent une partie de leur valeur. Si elles ne sont pas utilisées, alors c’est une perte sèche. Mais si elles sont utilisées de manière intensive, notamment pour de la génération d’images, il devient difficile de les reconditionner par la suite pour des projets de type Open Compute. C’est un peu comme acheter d’occasion une voiture de location en espérant que les clients en ont pris soin.

C’est donc là que se pose la vraie question : l’investissement colossal en puces doit être amorti sur une durée courte, un an, deux ans, trois ans, cinq ans. Est-ce possible ?

Surtout qu’Intel, AMD et d’autres n’ont pas l’intention de laisser Nvidia dominer ces marchés profitables. Les alternatives intéressantes arrivent désormais sur le marché, créant plus de confusion.

C’est ce qu’OpenAI a parfaitement compris. Cela explique pourquoi, un jour, ils dealent avec AMD, un autre avec Broadcom, oui, le même qui a acheté VMware et qui finance désormais sa stratégie IA en pressurisant ses clients européens.

Intel est lui-même à nouveau dans ce jeu.

Mais c’est Ranjan Roy (Margin, Big Technology Podcast) qui confirme implicitement que le deal entre OpenAI et Oracle (ainsi qu’avec AMD) s’est fait hors des circuits classiques des banques d’affaires. Les accords récents d’OpenAI (avec Oracle, AMD, CoreWeave…) sont des deals de CAPEX, pas des deals produits ou de financement traditionnels, et s’apparentent davantage à des échanges de compute, de crédits et de stock-options qu’à des transactions monétaires classiques.

Autrement dit, certains deals sont passés sur la base de relations directes et d’effets d’annonce, sans passer par une structuration financière complète. Il est donc très difficile pour les analystes de comprendre la réalité du deal. C’est sur cette base qu’OpenAI aurait signé ses engagements faramineux (jusqu’à 1 000 milliards $ d’infrastructure) sans disposer de revenus correspondants, et que ces montages ressemblent davantage à des accords “papier” de coopération stratégique qu’à de véritables deals d’investissement montés avec banques d’affaires ou conseils financiers.

Nous voici prévenus.

Deux choses sont importantes à rappeler :

- L’offre pléthorique et la capacité de compute n’ont jamais été aussi importantes dans l’histoire de l’humanité.

- Mais pour que ça marche, il faut de l’eau, de l’eau douce évidemment, qu’il faut prélever aux autres industries et aux usages quotidiens, mais aussi de l’énergie.

Il y a quelques semaines, quand nous avons vu tous les patrons de la tech passer la brosse à Donald Trump, en lui offrant des cadeaux et des compliments, j'estimait que la seule la véritable raison pour laquelle ces acteurs avaient besoin de lui n’était pas l’argent — qu’ils ont déjà —, ni le pouvoir — qu’ils ont déjà —, mais bien l’accès à l’énergie et une accélération des process par le gouvernement fédéral américain pour permettre la construction de centrales nucléaires. Avec deux centrales construites depuis Reagan, les États-Unis ont fait le pari de financer une technologie du XXIe siècle avec un réseau énergétique du XIXe siècle (cette formule n’est pas de moi mais je la trouve tellement juste).

Désormais, l’industrie de la tech n’est plus si différente de l’industrie pétrolière lorsqu’elle réclame des dérogations pour pouvoir forer en Alaska.

On pourrait penser que Donald Trump tient les patrons de la tech mais en réalité, le boom de l’IA aux États-Unis offre à Trump une véritable couverture politique : les retraites des Américains (et celles par capitalisation des Français) restent, pour l’instant, garanties par la flambée du NASDAQ.

Selon George Saravelos de Deutsche Bank, sans la dépense massive liée à l’intelligence artificielle — en particulier dans les data centers, les puces et le cloud —, l’économie américaine serait aujourd’hui proche de la récession, voire déjà en récession.

En 2025, les investissements dans l’IA devraient représenter près de 40 % de la contribution à la croissance du PIB américain, illustrant à quel point l’économie des États-Unis est devenue étroitement dépendante de ce cycle d’investissement.

George souligne cependant que ce boom n’est pas soutenable : il ne pourra se poursuivre que si les dépenses technologiques deviennent « paraboliques », un scénario jugé hautement improbable. En d’autres termes, si le CAPEX IA ralentit, la dynamique de soutien à la croissance s’essoufflera rapidement.

(toutes les sources sont disponibles à la fin pour nos abonnés payants)

Tech et administration américaines se tiennent désormais par la barbichette. La question qui se pose, c’est de savoir si la viabilité de l’économie américaine et, par extension, celle du reste du monde ne repose pas entièrement sur un pari sans plan B : la réussite de cette stratégie de conquête.

Ce pari va-t-il imploser ou non ?

La Chine, qui dispose désormais de sa propre technologie de puces (les puces Ascend ne sont pas encore au niveau de Nvidia mais s’en rapprochent), de coûts d’inférence réduits et de modèles de langage open source de qualité, n’a-t-elle pas déjà remporté la guerre de l’intelligence artificielle grand public ?

Et si, pour les entreprises américaines, le seul espace qui restait était celui de l’AGI ou de la super intelligence ?

Reste à comprendre pourquoi une telle accélération des investissements et une telle absence de garde-fous. Pourquoi vivons-nous dans un monde où, le même jour, OpenAI annonce travailler sur des chats érotiques, autrement dit des sexbots, tandis que Google et l’université de Yale utilisent une IA pour découvrir une nouvelle méthode permettant au corps de mieux repérer et attaquer certaines tumeurs cancéreuses ?

Enfin, on peut aussi se demander comment OpenAI prévoit de passer de douze milliards aux mille milliards de revenus qui seraient nécessaires pour couvrir ses “dettes” dans les cinq ans qui viennent.

Une question importante, car c’est à nouveau la Deutsche Bank qui soulève le lièvre : les revenus des abonnements en Europe sont en baisse.

Avec 800 millions d’utilisateurs, ChatGPT s’impose comme un immense succès auprès du grand public. La technologie du chatbot étant à usage général, il reste difficile de cerner précisément ses usages monétisables. Une amie VC de passage à Paris me confiait pourtant que les schémas de monétisation de l’IA sont désormais assez bien identifiés.

Suite pour les abonnés

Lire l'article complet

S'inscrire maintenant pour lire l'article complet et accéder à tous les articles déstinés aux payants abonnés.

S'abonner